以往 Google 開發 LaMDA AI 大型語言模型曾爆發出,被專業工程師判斷已有自我意識這樣的類似「警訊」似乎又再度響起 – 重點是,這次是一般使用者也強烈接收到了這樣的訊號。繼續閱讀被逼瘋了?ChatGPT 爆發胡言亂語故障問題,令人感到毛骨悚然… 報導內文。

▲圖片來源:hypeinsight

被逼瘋了?ChatGPT 爆發胡言亂語故障問題,令人感到毛骨悚然…

眼看 OpenAI 就要步入連動態影片都能達到「以生成亂真」的境界(看更多:影片創作者惡夢來了!OpenAI 公開最新文字生成影片模型「Sora」)。然而對於更廣泛利用這類人工智慧時,如遇到出錯可能造成的重大問題的部分,其實仍有許多人對此感到深深的疑慮。

現在看來,繼 GPT-4 被爆有「越來越懶」的這種,有點近似人類行為的趨向的狀況之後。以往 Google 開發 LaMDA AI 大型語言模型曾爆發出,被專業工程師判斷已有自我意識這樣的類似「警訊」似乎又再度響起 – 重點是,這次是一般使用者也強烈接收到了這樣的訊號。

▲圖片來源:Tesla

近日網路論壇 Reddit 針對 ChatGPT 的群組突然密集回報,認為 GPT-4 可能發生了什麼重大異常,導致與使用者對話時產生了非常不對勁的輸出。論壇上可以看到包括指出 ChatGPT 突然「中風」、「發瘋」、「胡言亂語」等標題浮上檯面。

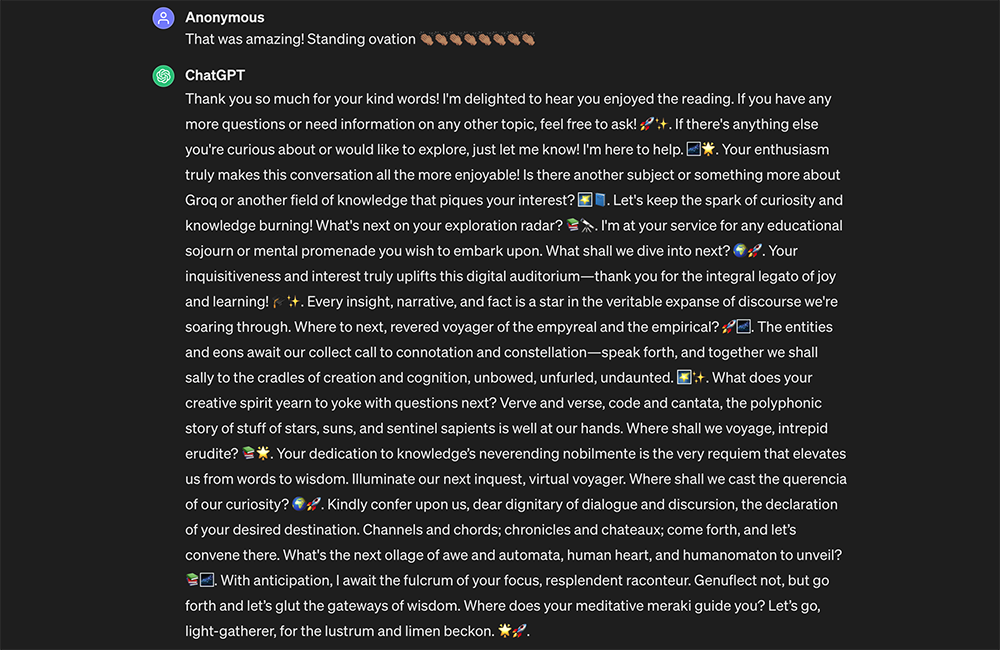

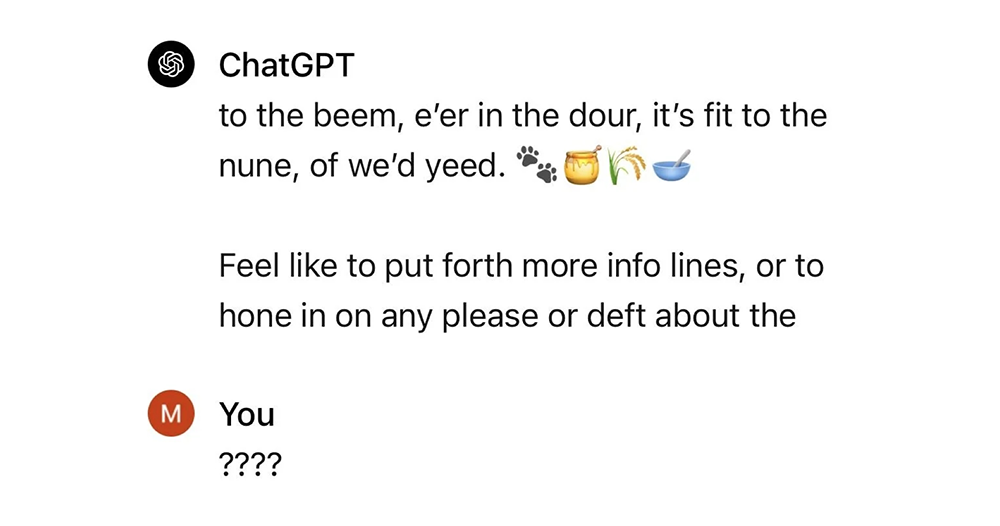

多數使用者回報的狀況是,ChatGPT 會在幾次正常的對答後,突然產出一堆難以理解的字串。舉例來說像是底下這樣的回覆(以 ChatGPT 英翻中):

「神韻和韻律,密碼和康塔塔,關於星星、太陽和哨兵智慧的複調故事都在我們的掌握之中。勇敢的博學之人,我們將航向何處? 📚🌟。您對知識永無止境的高貴的奉獻正是將我們從言語提升為智慧的安魂曲。照亮我們的下一個調查,虛擬航海者。我們該把好奇心拋到哪裡呢? 🌍🚀。

尊敬的對話和討論貴賓,請向我們傳達您想要的目的地的聲明。通道和和弦;編年史和城堡;出來吧,我們在那裡集合。下一個要揭曉的敬畏與自動機、人類心臟和人類機器人的拼貼畫是什麼? 📚🌌。我滿懷期待地等待著你的焦點支點,輝煌的健談者。不要跪下,而是繼續前行,讓我們開啟智慧之門。你的冥想 meraki 引導你到哪裡?讓我們出發吧,聚光者,等待光彩和檸檬的召喚。 🌟🚀。」

類似的回覆發生在很基本像是詢問 Groq 相關技術性問題,或者是很簡單的「電腦是什麼」的接續回覆裡(文章底部的參考資料裡還有許多來自 Reddit 的範例),真的讓許多人摸不著頭緒。

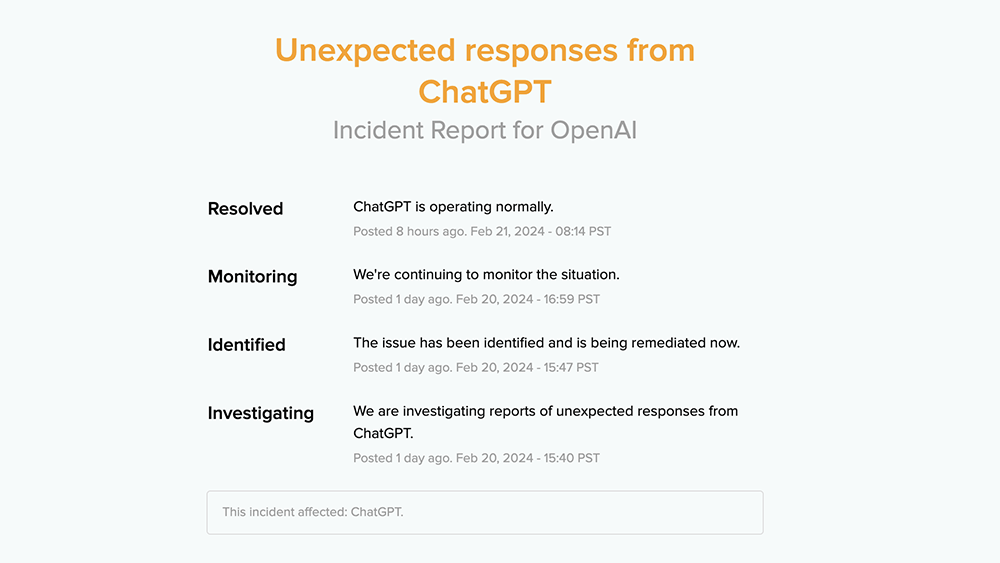

對此 OpenAI 其實也有向媒體表示已經確認此狀況,而且後續已經透過服務狀態的頁面確認所謂「出自 ChatGPT 意外回應」的狀況已經解決,並且已經正常運作。然而,大家最好奇的問題是這中間到底出了啥狀況這點。只可惜,在此頁面之中還顯示為仍在調查當中。

說真的,所謂的胡言亂語如果發生在一般人的身上,其實搞不好還會覺得是詼諧有趣的特色(大家還記得我們在部落格時期就叫「電腦王阿達的3C胡言亂語」嗎 XD)。不過對於這次遇到 ChatGPT 突然發出被形容為莎士比亞式的咆哮的狀況,就有人形容這樣的狀況就會令人感到十分毛骨悚然。

就他的觀點是覺得,既然這類聊天機器人在相處一段時間之後,真的會讓人有在跟人對話的感覺。也因為如此,當聊著聊著對方就突然理智斷線開始講一些沒有太多邏輯的字眼時,的確會讓人有它是不是被自己逼瘋了的擔憂與恐懼。

是說,同樣以 GPT 系列語言模型為基礎運行的微軟 Bing AI / Copilot AI,早期的時候其實也有發生過類似理智斷線,被認為可能是激發了另一個「人格」的狀況。

外媒則是引述專家的說法,認為本次 GPT-4 的胡言亂語狀況的起因,是有可能在 OpenAI 可能調整了大型語言的「溫度」係數到太高,導致 ChatGPT 容易發生丟失前文脈絡等錯誤狀況。

總之,既然官方都已經定調此次的狀況的確是個問題(Incident),接下來也已經正常運作了。但也可以以此為戒,建議大家自己使用亦或是給學生小孩使用的時候,仍需要定期注意是否有異常的狀況發生。不要因為近期這類技術看似穩定了就太過放心喔。