Bing Chat、ChatGPT 和其他類似的 AI 生成工具,多半主要專注於理解文字輸入指令的內容並提供答案,但是有時候你就只有一張參考圖片,其它難以言述怎麼辦?對於圖片 Bing Chat 祭出解決辦法,現在它可以讓你直接餵圖片並針對圖片提出問題,不用再絞盡腦汁解釋啦!

不單是文字指令,Bing Chat 現在也可以理解你的圖片了

在 Microsoft 最近的一篇部落格文章中,正式為 Bing Chat 推出一項名為「視覺搜尋」(Visual Search)的新功能。使用視覺搜尋,你可以直接在與 Bing Chat 的對話視窗中上傳畚箕圖片或是貼上圖片網址,AI 將嘗試理解它並且對你提出回應。Microsoft 的展示影片中,示範上傳一個網頁表單的手繪模型,並要求 Bing 生成 HTML 和 CSS 代碼以使其正常運行。

Microsoft 在文章中解釋道,無論你是去一個新的城市度假,詢問特定建築的建築,還是在家裡試圖根據冰箱裡的東西想出晚餐菜色,只要將圖片上傳到 Bing Chat 中,就可以透過它來利用網路的知識獲取答案與建議。

可以檢測圖像內容的軟體並不是什麼新鮮事。自 2017 年以來,Google 智慧鏡頭已經能夠識別照片中的人、動物、植物、地標和其他物體,其更有限的前身 Google Goggles 可以追溯到 2010 年。Microsoft 使用的是 GPT-4 的圖像檢測功能,這與高級版 ChatGPT 使用的語言模型相同,但是,圖像輸入在 ChatGPT 中尚不可使用,因此這是第一次看到該功能廣泛運用。想要使用視覺搜尋很簡單,只要打開 Bing Chat 後,點擊輸入框右側的鏡頭圖示,即可選擇新增影像的來源。這裡提供貼上圖片網址與從此裝置上傳兩種。

在圖片上可以加註你想要問的問題,運用在教育上也很有意義如下方的圖片所示,:

我用幾張照片進行視覺搜尋,結果令人印象深刻。Bing Chat 在圖像上的描述比從 Google 智慧鏡頭得到的回答更詳盡。例如,上傳我家小狗小時候的照片,並請它敘述,它的回覆是:「這是一張小狗在床上睡覺的照片。小狗是淺棕色的,有一個黑色的鼻子和閉著的眼睛。床上有一條藍色的毯子和一個帶有藍色圓點的白色床單。小狗旁邊有一個棕色的毛絨絨動物和一個繩索玩具。背景是一個金屬線籠。」連帶將背景、整體細節都描述得很完整,還提供建議延伸問題。

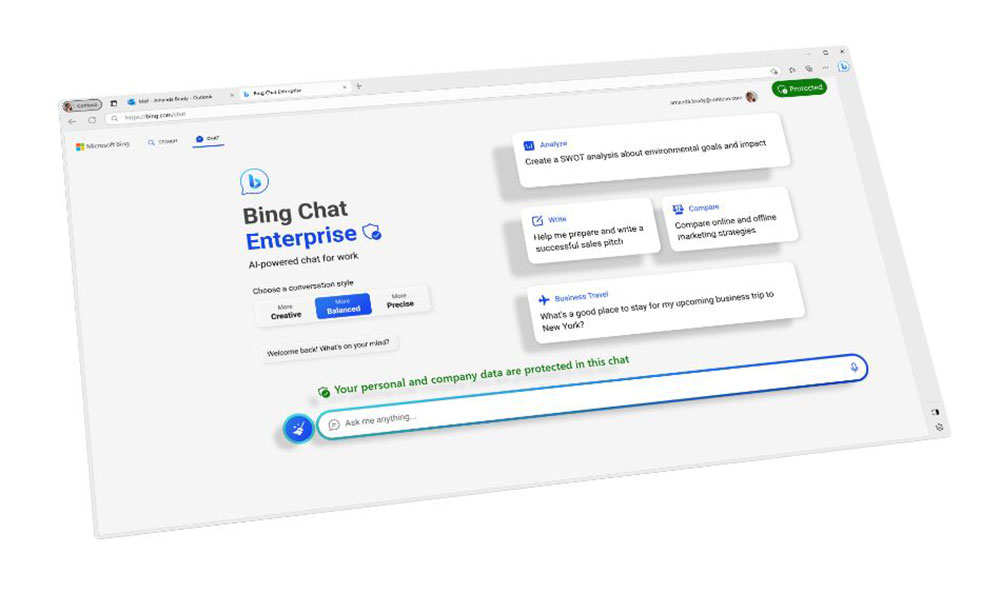

這項功能現在已經在正式版本上推出,建議還是從 Microsoft Edge 上使用最穩定,現在就去試試看吧!