對於 AI 人工智慧領域,很多軟體大廠都認為這是未來新趨勢,並努力投入在其中。Google 身為搜尋領域龍頭自然也有自己的一套,但除了要有好的軟體來讓 AI 發揮能力,甚至能做到深度學習,還得要有硬體的幫忙,雖說現成的硬體中,Intel 與 NVIDIA 也在這一塊有所耕耘,但 Google 也同樣認為「硬體也可以自己做」的情況下,蹦出了一個叫做 TPU (Tensor Processing Units,張量處理器)的新晶片,而這個晶片卻讓在 AI 領域有不錯成績的 NVIDIA 與半導體大廠 Intel 倍感壓力,為什麼呢?

▲許多影視作品都跟 AI 或多或少有些關係,左圖為攻殼機動隊,右圖為電腦情人夢

為了解決人工神經網路能力日益增長後產生的問題,Google 設計了自己的 TPU 來執行這些工作,現階段 Google 的目標是從 2013 年起,將深層人工神經網路的成本績效要高於 10 倍 GPU 效能,這些說法來自於 Google 的論文「In-Datacenter Performance Analysis of a Tensor Processing Unit」。

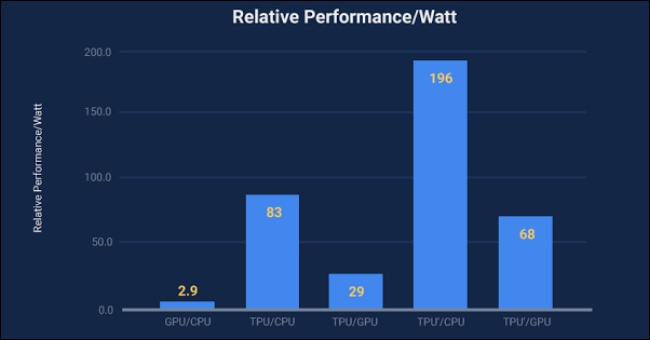

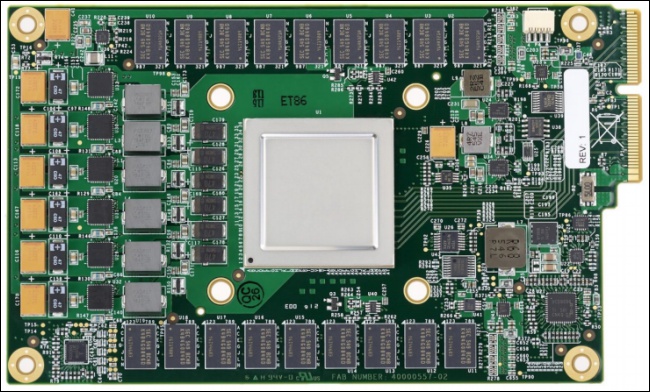

Google TPU 晶片在 2016 年的 Google I/O 大會上就亮相過,但沒有公開太多的細節資料,或許是因為這個晶片還沒有開發到最完美的程度,但這陣子 Google 在自家部落格上突然談到 TPU ,也公開不少資料,甚至也跟一些 Intel Haswell CPU 與 NVIDIA K80 GPU 來個小小的對決,對覺得內容為處理機器學習後的表現,而 TPU 在這方面比傳統 CPU + GPU 組合的表現快了 15 至 30 倍,表現出 TPU 的專長領域確實跟人工智慧深度學習的領域有很大關係:

※圖片來源

但這次測試也有些問題,首先這項測試專注在 AI 學習後的結果,前半段用大量數據訓練人工神經元的部分以舊晶片處理,至於功耗方面,Google TPU 有著比過往晶片組合優秀的表現,能耗比領先 30 至 80 倍。即便 TPU 還有待改進的地方,但對於深耕人工智慧領域的 NVIDIA 與 Intel 來說是一大警訊,意想不到的對手帶著自己的人工智慧晶片出來叫陣了,自家產品能不能彎道超車,都還得靠這方面的人才與資源來達成:

Google TPU 的運作方式並非取代 CPU ,而是以協同處理器的方式在系統中運作,例如透過 PCI-E 匯流排與系統上的 CPU 協同運作,Google 的開發團對表示,是由 Server 主機向 TPU 發出指令,而不是 TPU 自己提取指令,因此 TPU 與 FPU(浮點處理器) 協同處理器比起來,更像是 GPU 的定位。Google 並沒有要打造出最強最厲害的 TPU ,即便在 AI 領域已經有不錯的表現,但 Google 認為 TPU 更適合大規模部屬。Intel 不久前已經宣布今年將推出 AI 專用的晶片,相信 NVIDIA 也會做點什麼來避免落於下風。人工智慧除了軟體領域引起熱潮,相信硬體領域也有大廠們互相較勁。