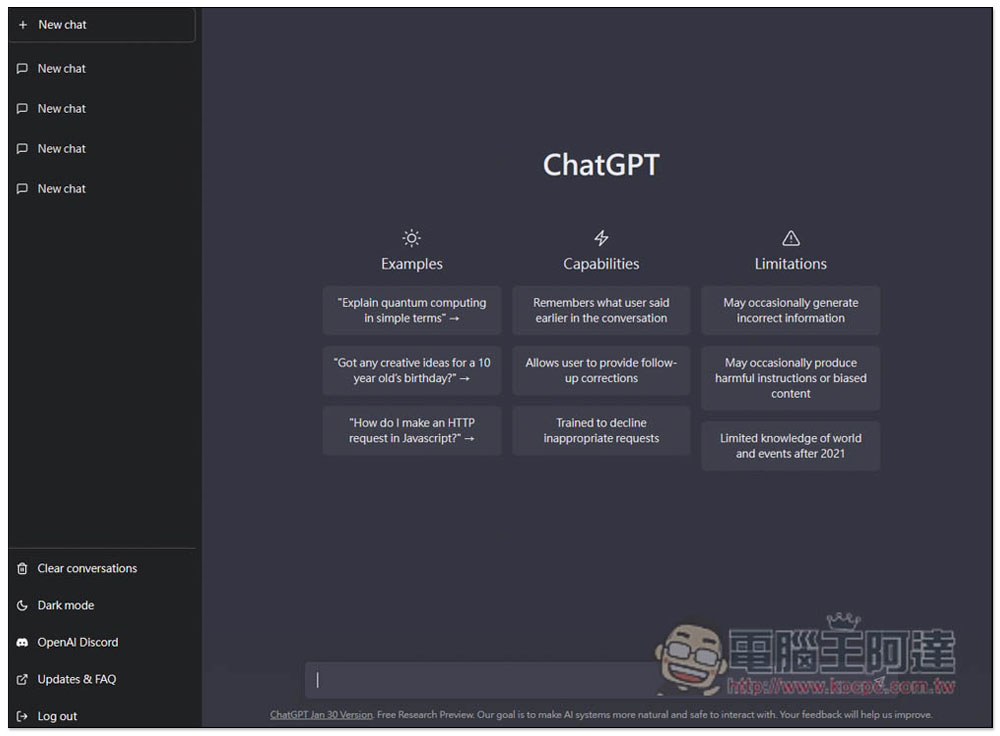

ChatGPT 是 OpenAI 最新且最重要的大型語言模型(LLM),在自然語言對話中表現相當出色,從 2022 年 11 月首次推出以來,令人驚訝的聊天機器人一直是新聞報導中的亮點。到目前為止我們已經看到很多實例,其中模型已經能夠用合理和連貫的文句來表達,人們開始動起投機取巧的腦筋,將 AI 生成內容充當自己所寫,那麼問題來了: ChatGPT 來寫論文或報告可靠嗎?

為什麼用 Chat GPT 幫你寫報告是不值得的冒險?

既然 ChatGPT 已經可以對答如流,那麼學生開始用 ChatGPT 來幫忙寫作業也不足為奇,但與此同時也引發了關於 AI 在整個寫作、教育作用的大量辯論。在國外一些學校和大學已經宣布嚴格禁止使用這項技術,部分教育工作者也回報抓到使用 ChatGPT 作弊的學生。如果你正在考慮將論文、報告交給 ChatGPT 處理,請務必考慮自己將會承擔的風險,還有下面這些讓你重新思考的理由。

有些工具可以發現 AI 生成的文字

你可能會僥倖地想,應該很難發現一段文字是否由類似 ChatGPT 的模型所生成,但事實上並非如此。AI 工具和其他類似的工具快速增長同時也刺激了以發現 AI 生成文字為目標的工具開發,而這種檢測科學才剛剛開始。例如,2023 年 1 月提出的研究中指出,使用機器學習模型來識別人類建立的文字與 ChatGPT 等聊天機器人生成的文字時,準確率已可達 79%。

教授和老師可以裡用多種工具來快速分析學生的報告、論文,並且可告估計該篇內容是否由 AI 所生成。其中一種工具名為 GPTZero,它已經擁有超過 100 萬的使用者;另一款工具名為 OpenAI Detector,主要用來檢查兩年前推出的 GPT-2019 生成的內容。一旦此類工具將你的作業標記為不誠實,很可能會讓你受到懲罰,具體還是取決於你所屬的學校政策。

AI 可能會給你不正確的資訊

OpenAI 表示,它與早期模型之間的合作可以生成更高品質的內容,包括減少虛假數據等,儘管如此,ChatGPT 仍然傾向於以看起來很可靠的方式來呈現不正確的資訊。從本質上來說,ChatGTP 只是一個自我迴歸模型,它學習在給予的特定上下文情況下預測下一個單詞,簡而言之,它沒有推理或定義明確的知識庫來生成文字。因此,至少與傳統的 Google 搜尋相比,該模型不太可靠,所以將 ChatGPT 用在專業和學術環境中可能會適得其反。

舉例來說,微軟的 Bing Chat 和 Google 的 Bard 聊天機器人在各自的發表會上都提供了不正確的資訊。在微軟的案例中,它的 AI 甚至生成了完全虛構的情節,包含 Bing 在比較寵物吸塵器時所犯的一些錯誤,更不用說提供有關墨西哥酒吧虛假細節和錯誤地總結季度財務報告。雖然是不正確的內容卻用一種聽起來具權威和值得信賴的方式呈現,讓閱聽者很容易信以為真。

Business Insider 報導中,一位教授發現學生正在使用 AI 作弊,因為他們的文章用很好的修辭與寫作方式描述了錯誤的事實。另一位教育工作者解釋道,雖然 AI 生成的論文可能會在修辭上打磨地很好,但內容往往是浮泛而缺乏實際內容。這種明顯的指標與 AI 檢測工具相互搭配,將會讓以 ChatGPT 寫作的報告、論文很快就被識破,而且這種情況短時間內不太可能有所改變。